UPDATE

On en parle dans la presse :

Il y a un peu plus d’un an, l’initiative TRAIL était lancée pour booster la recherche en IA et que celle-ci puisse permettre un coup d’accélérateur dans ce domaine stratégique en Région Wallonne en facilitant l’adoption de l’IA par le tissu socio-économique:

https://www.uwe.be/trail-trusted-a-i-labs/

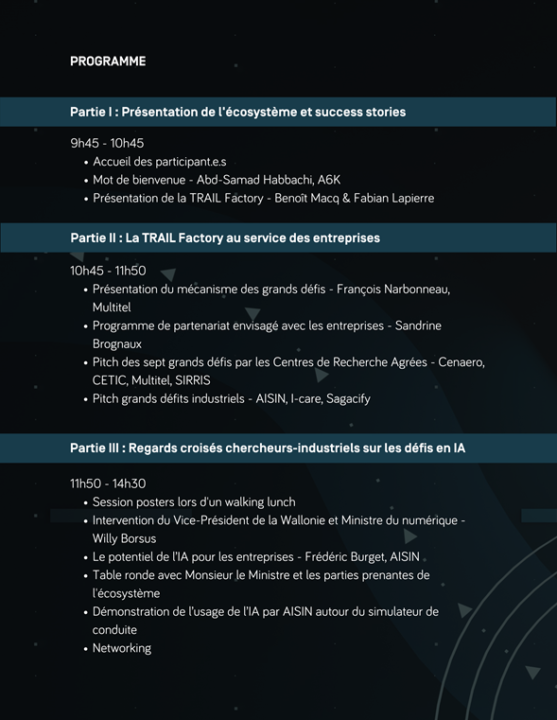

Le vendredi 6 mai, cette volonté est devenue une réalité avec la rencontre d’acteurs industriels clefs tels qu’AISIN, I-care, Sagacify et d’autres entreprises utilisatrices d’IA, mais également prestataires de services en IA. Cette rencontre s’est fait dans les locaux d’A6K. A cette occasion, plus de 150 personnes issues du monde académique, du monde industriel et des acteurs publics actifs dans ce domaine ont échangé sur leurs défis technologiques. Le but étant de mettre les savoirs et ressources en commun afin de permettre à la Wallonie de se positionner parmi les écosystèmes IA reconnus en Europe.